¿La IA entiende o sólo “estudia de memoria”?

¿Puede una inteligencia artificial realmente "entender"? La creciente sofisticación de los modelos de lenguaje plantea esta pregunta en un contexto fascinante. En su análisis, el autor explora cómo el "Pattern Matching" y los límites en el razonamiento matemático muestran que estos sistemas aún dependen en gran medida de patrones y datos previos. Aunque la IA está más avanzada que nunca en prever respuestas y simular lógica, los desafíos actuales revelan que la comprensión humana sigue siendo única.

IA, INNOVACIÓN Y TECNOLOGÍADESTACADOS

¿La IA entiende o sólo “estudia de memoria”?

¿Son las máquinas capaces de pensar, razonar y sentir? ¿Lo harán en mayor o menor medida que nosotros? Si lo hacen, ¿es de una forma diferente a la nuestra? En el caso de las primeras dos preguntas, aún nadie ha sido capaz de ofrecer respuestas concluyentes. Lo que sí podemos decir es que su “pensamiento” es, sin lugar a duda, diferente al nuestro.

Pattern Matching, ¿la conciencia digital?

El Pattern Matching es una técnica que busca referencias o patrones definidos en los datos que usó para entrenarse, es decir, compara datos buscando coincidencias absolutas. Es un asunto binario, de sí o no.

El ejemplo más sencillo de esto es el del algoritmo que busca palabras específicas en un texto. Otra de sus características clave es que, al estar basado en reglas claras predefinidas, es altamente predecible y reproducible. Dado un input, la respuesta será siempre la misma.

El lenguaje natural es sumamente complejo y tiene una gran variabilidad. Una misma idea puede expresarse de múltiples maneras sin cambiar su significado. El pattern matching tradicional, basado en coincidencias exactas, no logra imitar esta flexibilidad del pensamiento humano. Por ello, los modelos de lenguaje modernos, como GPT, emplean una variante llamada Pattern Matching Probabilístico. En lugar de buscar patrones exactos de forma determinista, esta técnica utiliza herramientas estadísticas y datos previamente aprendidos para prever respuestas. Así, los modelos pueden gestionar mejor la variabilidad y complejidad del lenguaje.

¿Los modelos de lenguaje entienden o sólo estudian de memoria?

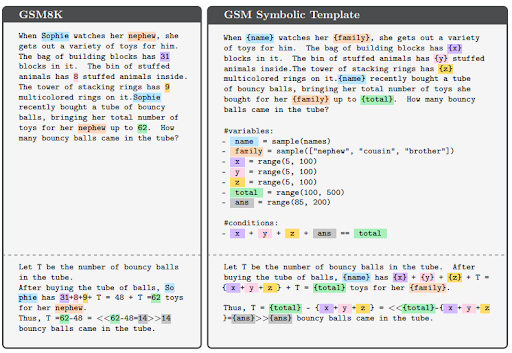

Un reciente paper de un equipo de investigación de Apple buscó responder a una pregunta parecida. Realizaron varios experimentos para entender las limitaciones del razonamiento matemático de estos modelos. Tomaron como referencia inicial un dataset (conjunto de datos) de entrenamiento de modelos de lenguaje llamado GSM8K (Grade School Math 8K).

El GSM8K se trata de un conjunto de datos de alta calidad compuesto por 8,500 problemas matemáticos de nivel primario con diversidad lingüística. Los problemas incluyen únicamente las cuatro operaciones aritméticas básicas: suma, resta, división y multiplicación. Aunque estudios previos demuestran que técnicas como el Chain-of-Thought prompting y la incorporación de una memoria temporal son efectivas, los resultados también revelan que estos modelos son sensibles a cambios mínimos, lo cual evidencia sus limitaciones para realizar razonamientos formales.

Se propusieron realizar distintos tipos de modificaciones al dataset GSM8K con el objetivo de observar qué sucedía con la precisión en los resultados. GSM-Symbolic es la primera variante de su experimento y sólo remueve nombres y le pone un rango a las variables de los problemas:

Los resultados de muchos modelos de lenguaje actuales muestran una gran variabilidad, lo que reduce su desempeño, tal como era de esperarse. La precisión de las respuestas se evaluó bajo tres tipos de cambios en los problemas: alterando solo los nombres; solo los números (usando números más grandes y menos comunes); y variando ambos parámetros al mismo tiempo. Los resultados indican que los modelos tienen mejor desempeño al cambiar solo los nombres, seguido por el cambio solo de los números, y finalmente, el menor nivel de precisión se observa cuando se modifican tanto nombres como números.

No conformes aún, realizan un conjunto de variantes al dataset GSM-Symbolic. Una variación que a los problemas les quita alguna cláusula, haciéndolo más fácil (GSM-M1). También generan dos variaciones que agregan una y dos cláusulas, GSM-P1 y GSM-P2 respectivamente.

Los resultados decrecen rápidamente de izquierda a derecha en dificultad de los problemas, como podríamos esperar, basados en cómo es que están implementados los modelos.

Finalmente, para terminar de darle robustez a los resultados, incorporan una última modificación al dataset que se llama GSM-NoOp. Esta modificación incorpora cláusulas o información irrelevante para el problema con el objetivo de confundir al modelo en la resolución del problema. Un ejemplo de esto es agregar información descriptiva sobre los objetos que estamos intentando contar, no olvidemos que son problemas de matemática de primaria, que puedan sugerir alguna operación extra pero en realidad no sea así. Los resultados de este último dataset son los más bajos ya que entienden a estas descripciones que no agregan información relevante para resolver el problema con alguna operación básica a hacer. El ejemplo que ellos usan es que, al estar contando frutas, describen a algunas como más pequeñas que el promedio. Esto lo interpreta como frutas a restar del total cuando en realidad no debería suceder.

Este comportamiento se agrava al aumentar la complejidad de las preguntas relacionadas a la matemática. Por experiencia propia, hay veces en las que intenta responder a una pregunta y siempre encuentra la forma de darte una respuesta que demuestre tu pregunta con poca rigurosidad y asumiendo erróneamente propiedades o hipótesis para poder responder “correctamente”.

Aunque los avances en este campo son impresionantes, y los algoritmos pueden “identificar” patrones y razonar basándose en modelos de razonamiento humano previos que forman parte de su entrenamiento, aún no logran generar razonamientos verdaderamente nuevos. Queda mucho por investigar y comprender para acercar a los modelos de lenguaje a un tipo de razonamiento que se asemeje más al humano.